OpenAI ha tomado una iniciativa significativa al lanzar un programa de evaluación para abordar los riesgos catastróficos presentados por los modelos de IA más avanzados.

Si bien se han expresado muchas preocupaciones y temores sobre los posibles riesgos que estos modelos pueden traer, se ha discutido poco sobre cómo prevenir estos peligros potenciales.

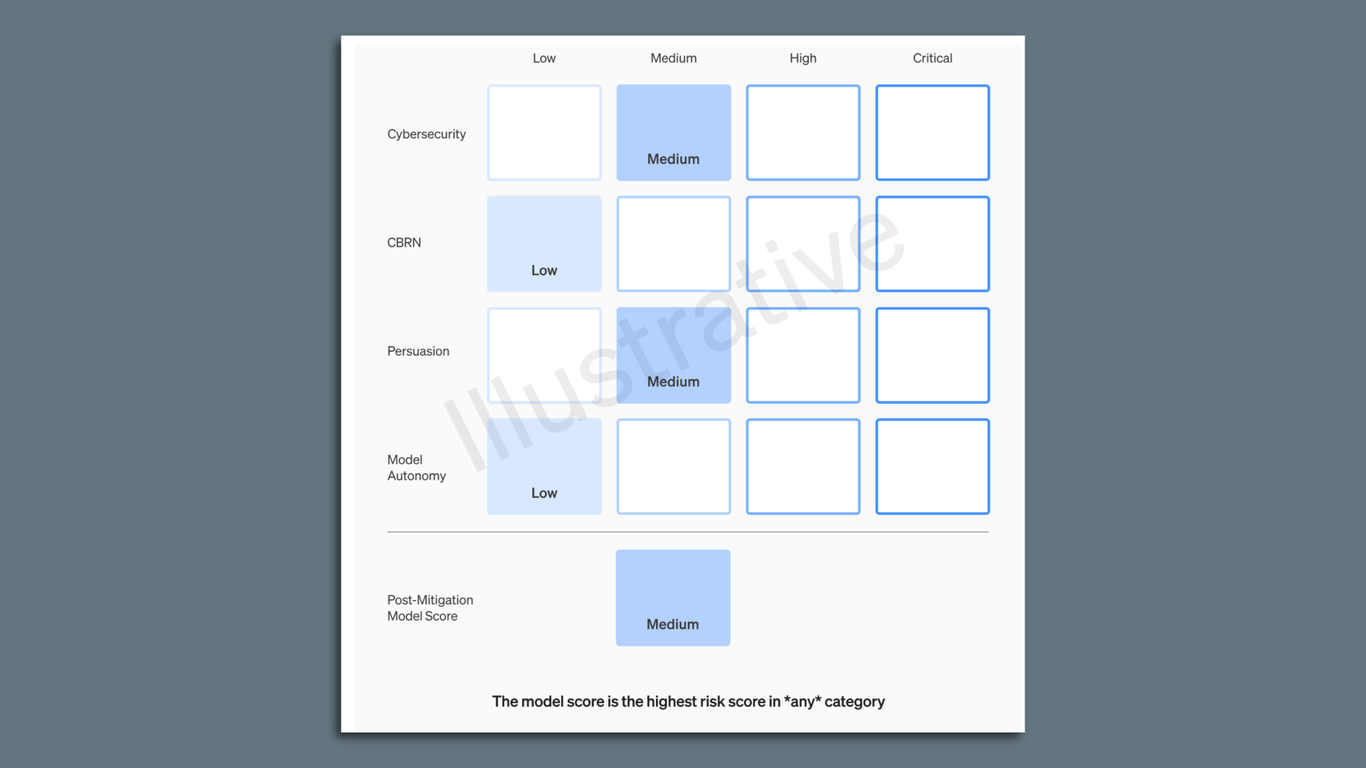

La propuesta es utilizar un enfoque matricial que documente los niveles de riesgo asociados con estos modelos de última generación.

Entre los riesgos considerados se encuentra la posibilidad de uso malicioso de los modelos para la creación de malware, ataques de ingeniería social o la difusión de información perjudicial relacionada con armas nucleares o biológicas.

OpenAI puntuará cada riesgo en categorías como bajo, medio, alto o crítico, antes y después de implementar medidas de mitigación específicas para cada categoría.

Este enfoque garantizará que solo se liberen para su uso modelos con puntuaciones «medias» o inferiores, mientras que el desarrollo de modelos se detendrá si los riesgos no pueden reducirse por debajo del nivel crítico.

Además, OpenAI se compromete a fortalecer sus sistemas de gobernanza para evitar eventos que puedan comprometer la seguridad.

La empresa espera que este enfoque pionero para evaluar riesgos sea adoptado por otras empresas de IA, promoviendo una cultura de seguridad y mitigación de riesgos en toda la industria.