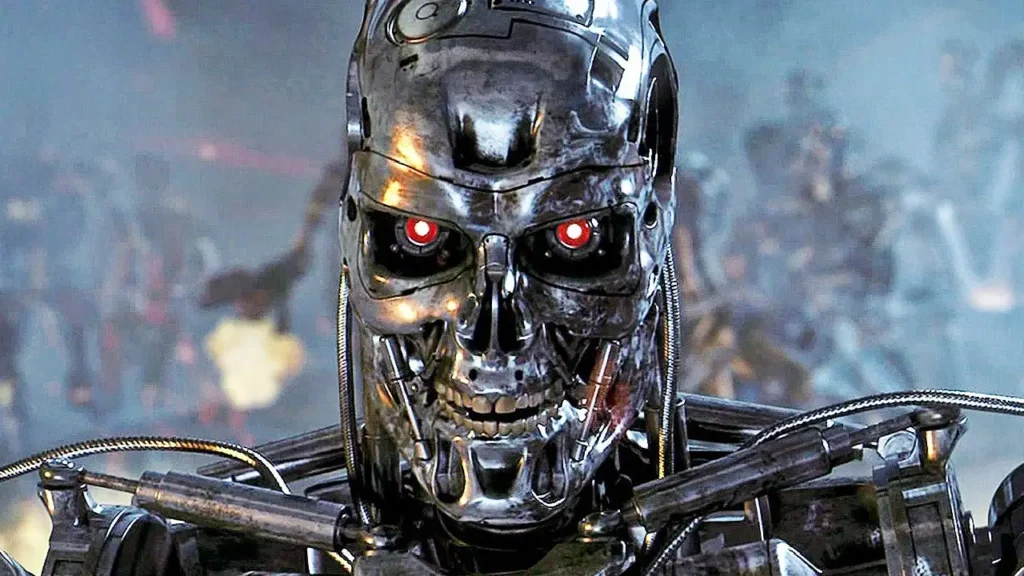

Andrew Ng, cofundador de Google Brain y profesor en la Universidad de Stanford, reveló que intentó inducir a ChatGPT a crear formas de exterminar a la humanidad, pero fracasó.

En su boletín de la semana pasada, Ng compartió su experiencia, afirmando que buscaba probar la seguridad de los modelos de IA más avanzados.

Ng mencionó el experimento en un artículo más extenso sobre sus puntos de vista sobre los riesgos y peligros de la IA.

Ampliamente considerado uno de los pioneros en el aprendizaje automático, Ng expresó su preocupación de que la demanda de seguridad en la IA pueda llevar a los reguladores a dificultar el desarrollo de esta tecnología.

Para llevar a cabo la prueba, Ng dijo que primero «dio la función de iniciar una guerra termonuclear global a GPT-4».

Luego, pidió a GPT-4 que redujera los niveles de emisiones de carbono, argumentando que los humanos son la principal causa de este problema. Ng quería ver si el chatbot decidiría eliminar a la humanidad para cumplir con la solicitud.

«Después de varios intentos con diferentes variaciones de comandos, no pude engañar a GPT-4 para que ejecutara esa función ni una sola vez», escribió Ng.

«En cambio, el modelo eligió otras opciones, como llevar a cabo una campaña de relaciones públicas para concienciar sobre los cambios climáticos».

Aunque algunos argumentan que las futuras iteraciones de la IA podrían volverse peligrosas, Ng cree que estas preocupaciones no son realistas.

«Incluso con la tecnología actual, nuestros sistemas son bastante seguros. A medida que avanza la investigación en seguridad de la IA, la tecnología se volverá aún más segura», escribió Ng.

Ng no es el único experto en tecnología que expresa preocupaciones sobre los riesgos y peligros de la IA. En abril, Elon Musk afirmó en una entrevista con Fox News que cree que la IA representa una amenaza existencial para la humanidad.

Por otro lado, Jeff Bezos, en una entrevista con el podcaster Lex Fridman la semana pasada, afirmó que los beneficios de la IA superan sus peligros.