Si hoy escribes un refrán completamente inventado en Google, es probable que recibas una respuesta con una explicación detallada como si ese término formara parte del vocabulario popular.

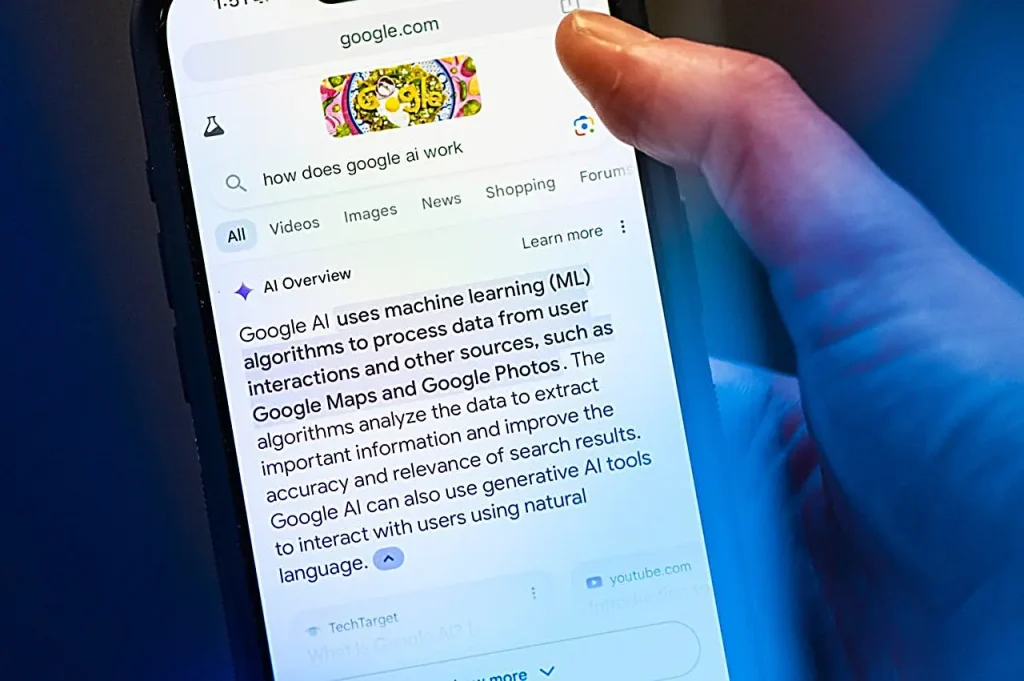

Esta situación curiosa está llamando la atención de los usuarios en las redes sociales y plantea interrogantes sobre el funcionamiento de la herramienta AI Overviews de Google, actualmente en pruebas en algunos países.

El recurso, que aparece en la parte superior de las búsquedas con un resumen generado por inteligencia artificial, fue diseñado para ayudar a los usuarios a entender información rápidamente, sin necesidad de abrir varios enlaces.

Sin embargo, también ha demostrado un comportamiento peculiar: al recibir frases sin sentido —como «no puedes lamer a un tejón dos veces»— el sistema intenta atribuir un significado coherente, como si estuviera tratando con una expresión legítima.

Este fenómeno incluso ha recibido un apodo: «AI-splaining», como lo llamó Lily Ray, especialista en SEO. El término juega con el hecho de que la IA, incluso sin una base real, «inventa» explicaciones con seguridad, a menudo sin dejar claro que eso fue fabricado.

La idea detrás de esto está relacionada con la forma en que funcionan los modelos de lenguaje: están entrenados para siempre intentar ofrecer una respuesta, incluso cuando los datos son insuficientes.

Aunque muchos de los resultados parecen inofensivos (e incluso graciosos), hay un lado preocupante.

En otras situaciones, como en el pasado, la misma herramienta ya ha presentado información errónea sobre temas serios, como reglas de la NFL, alimentación o primeros auxilios.

Google advierte que el recurso aún está en desarrollo y puede contener errores, pero el hecho de que permanezca destacado en los resultados refuerza la importancia de usarlo con sentido crítico.

Después de todo, no todo lo que afirma la IA debe tomarse al pie de la letra.