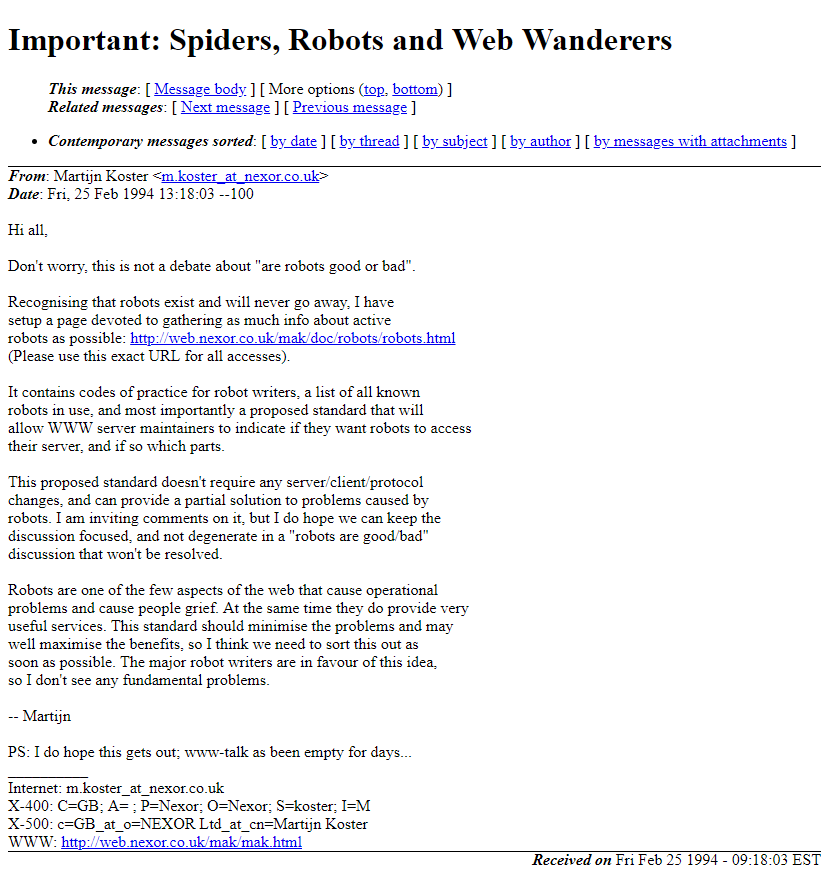

El 3 de julio de 1994, Martijn Koster, un investigador en ciencias de la computación de la Universidad de Nijmegen, en los Países Bajos, presentó el estándar robots.txt como parte de la lista de discusión www-talk de W3C.

Este estándar fue creado para permitir que los propietarios de sitios web restrinjan el acceso de los robots web a ciertas partes del sitio, como páginas de inicio de sesión o información confidencial.

El robots.txt es un archivo de texto simple que indica a los robots de búsqueda qué páginas de un sitio web pueden ser rastreadas y cuáles deben ser ignoradas.

Se coloca en la raíz del sitio y contiene instrucciones para los robots de búsqueda sobre cómo deben comportarse al rastrear el sitio.

El estándar robots.txt se ha adoptado ampliamente y ahora es una parte fundamental de la arquitectura web. La mayoría de los sitios web utilizan el robots.txt para controlar el acceso de los robots a sus páginas.

Si bien el robots.txt no es una solución perfecta para todos los problemas de privacidad en la web, es una herramienta importante que ayuda a que la web sea más segura y protegida.

Google, en particular, depende en gran medida del robots.txt para rastrear la web de manera eficiente.

El Googlebot, el robot de rastreo de Google, sigue las instrucciones del robots.txt para evitar el rastreo de áreas no autorizadas de un sitio.

Esto ayuda a garantizar que Google muestre solo contenido relevante y seguro en sus resultados de búsqueda.